Dans cet article, nous allons vous présenter 2 sujets utiles qui participent à l’amélioration du SEO on-site : le fichier robots.txt et le sitemap. Néanmoins, l’amélioration de ces éléments n’est pas indispensable car ils n’impactent pas votre stratégie de netlinking. Ils vous permettent surtout d’économiser du « jus SEO » et d’être visible auprès de Google.

Présentation du fichier robots.txt

Pour cette partie, nous allons un peu entrer dans des considérations techniques. Le fichier robots.txt se trouve à la racine de l’hôte du site auquel il se rapporte. Si vous utilisez un FTP comme FileZilla par exemple, vous trouverez ce fichier au même endroit que le fichier « .htaccess », c’est-à-dire dans le dossier qui contient tous les fichiers du site. Bref. Sur ce fichier, vous pouvez noter des instructions à destination des algorithmes qui crawlent votre site. Vous pouvez :

- Interdire le crawl de votre site par certains moteurs de recherche : Yandex, Bing par exemple

- Interdire le crawl et donc le référencement d’une partie de votre site :

- Page de connexion

- Dossiers ou fichiers sensibles/personnels

Pourquoi faire cela ? Pour plusieurs raisons. Vous pouvez interdire le crawl par certains moteurs de recherche car vous ne voulez être référencé(e) que sur Google par exemple. Ou alors, vous pourriez ne pas faire confiance à certains algorithmes pour des questions de sécurité et donc leur interdire le crawl de votre site.

Interdire le crawl d’une partie de votre site peut s’expliquer par d’autres raisons également. Par exemple, vous pourriez avoir des fichiers personnels sur votre site, que vous voulez garder cachés. Sachant que le mieux, c’est de ne pas avoir de fichiers personnels sur son site !

De plus, il faut savoir que quand Google crawle un site, l’algorithme dispose d’un « budget crawl ». En fait, Google ne va pas crawler votre site entièrement à chaque passage, cela serait trop chronophage et consommateur de bande passante. Il ne va lire que les sections les plus importantes. D’où l’intérêt d’ailleurs de bien structurer son site et mettre en avant son contenu pour faciliter l’analyse de Google ! A ce propos, n’hésitez pas à lire notre article sur l’optimisation de l’architecture de son site web.

Donc, quand vous dites explicitement à Google de ne pas crawler certaines parties du site, cela vous fait économiser du budget crawl. Et Google se focalisera sur les sections les plus importantes de votre site.

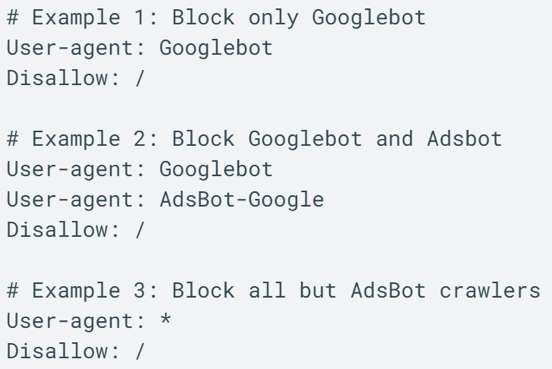

Gestion du fichier robots.txt

Pour gérer le fichier robots.txt, vous avez plusieurs possibilités :

- Création manuelle :

- Récupérer des codes types sur Google

- Vérifier que le code fonctionne bien et qu’il ne manque rien

- Importer le fichier dans le dossier à la racine de l’hôte du site Web

- Utiliser un FTP du type FileZilla

- Ou bien, utiliser un plugin pour simplifier les opérations !

Aujourd’hui, il existe de nombreux outils permettant de gérer le fichier robots.txt. Le plus connu étant très certainement Yoast SEO.

Voici un exemple de fichier robots.txt :

Robots.txt et sitemap sont les 2 sujets centraux de cet article. Nous vous avons présenté le fichier robots.txt. Nous allons maintenant voir ensemble le sitemap.

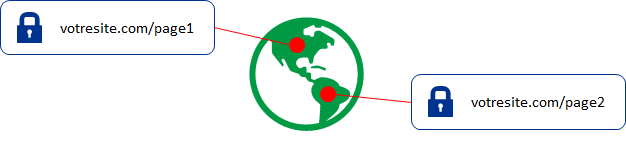

Sitemap XML – définition

Le sitemap XML quant à lui est une cartographie de l’ensemble des pages du site que l’on souhaite indexer. Il est possible de l’envoyer régulièrement via la Search Console pour que Google crawle votre site plus rapidement. En faisant cela, c’est comme si vous disiez à Google « J’ai ajouté du contenu nouveau sur mon site, tu peux venir l’analyser ». Par ailleurs, l’autre utilité du sitemap c’est qu’il vous permet d’afficher un plan du site. Vous trouvez parfois certains sites avec un lien « Plan du site ». En fait, ils utilisent le sitemap XML, avec une belle mise en forme.

A noter que l’URL du sitemap est du type :

https://www.domaine.com/sitemap_index.xml

C’est donc une page comme une autre au sein du site. Encore une fois, comme pour le fichier robots.txt, vous pouvez gérer le sitemap XML avec l’outil Yoast SEO.

N.B : l’optimisation du fichier robots.txt et du sitemap n’est pas indispensable pour un bon SEO et ne garantit en rien un meilleur positionnement sur Google. Un bon site avec du contenu de qualité et un SEO efficace sera de toute façon crawlé régulièrement par Google.